obkrov

Создатель

- Регистрация

- 26 Мар 2013

- Сообщения

- 22

- Реакции

- 29

- Автор темы

- #1

Добрый день!

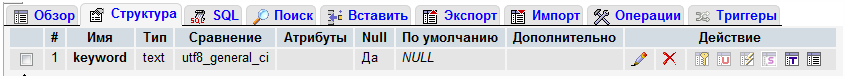

Есть таблица nTable (myIsam) с одним полем nKey (Text), индексы отсутствуют, длина строки 70-80 байт.

Таблица имеет 1 миллиард строк (это ключи для СЕО) около 30% это дубли!

Как грамотно удалить эти дубли и сделать все строки уникальными?

Комп имеет 2 диска (SSD и HDD, 8 Гб ОЗУ).

Помогите, пожалуйста, третий день уже бьюсь, и безрезультатно

Есть таблица nTable (myIsam) с одним полем nKey (Text), индексы отсутствуют, длина строки 70-80 байт.

Таблица имеет 1 миллиард строк (это ключи для СЕО) около 30% это дубли!

Как грамотно удалить эти дубли и сделать все строки уникальными?

Комп имеет 2 диска (SSD и HDD, 8 Гб ОЗУ).

Помогите, пожалуйста, третий день уже бьюсь, и безрезультатно